EU AI法の概要と日本企業に必要な対応を解説 よくある質問をまとめたQ&Aも紹介

IT・情報セキュリティ

目次

EUにおいてAIモデル・AIシステムを規制するAI法が、2024年8月1日に発効しました。同法は、EU域内の統一ルールを定めてAI の安全性や信頼性の向上を図り、 EUにおける AIの利活用やイノベーション等を促進することを目的とする法律です。

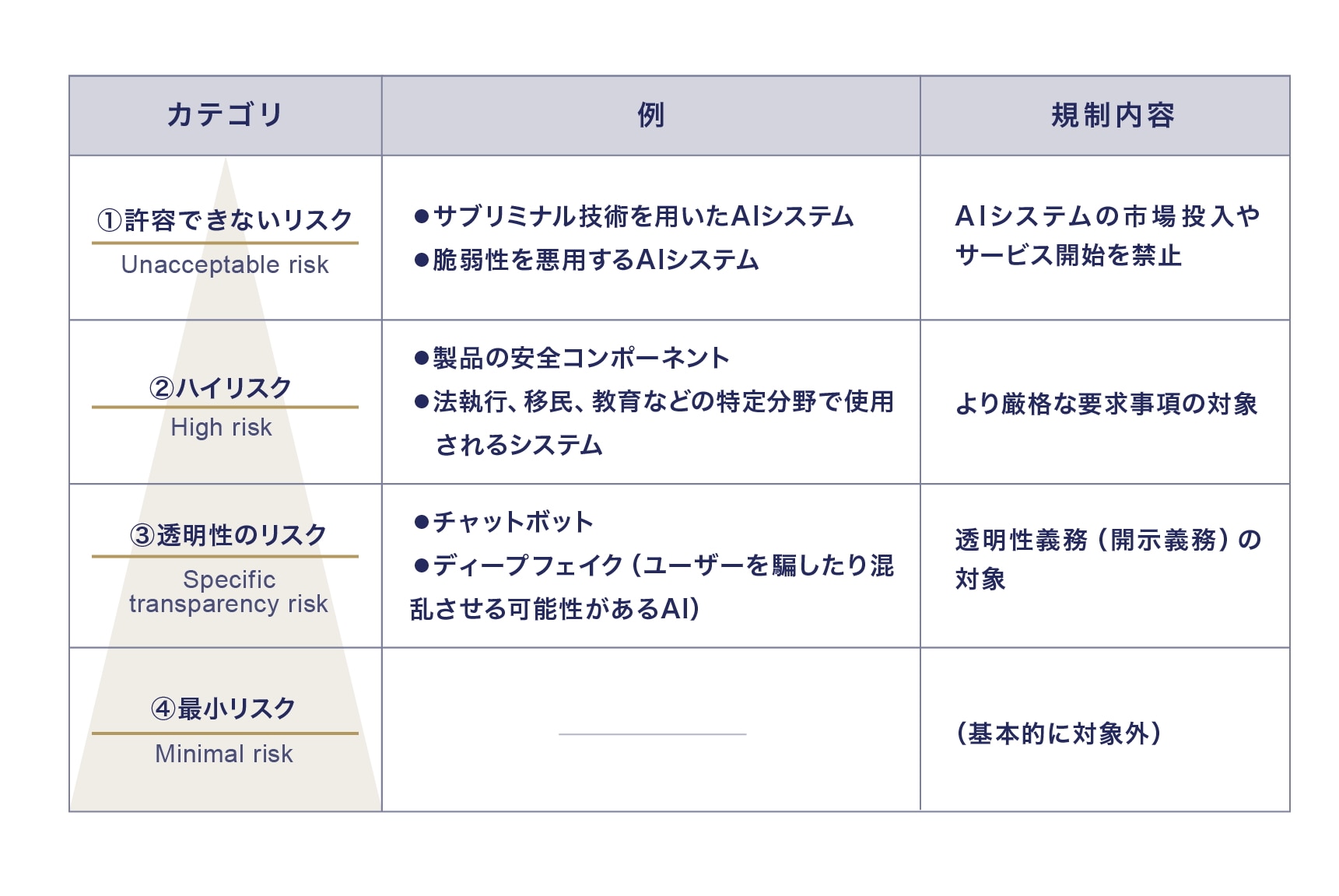

AI法はリスクベースアプローチを採用し、「AIシステム」を①許容できないリスク、②ハイリスク、③透明性のリスク、④最小リスクの4つのカテゴリに分類し、リスクがより高いAIシステムについて、より厳格な要件を定めています。さらに、「汎用目的AI(GPAI)モデル」についての規制も設けられています。

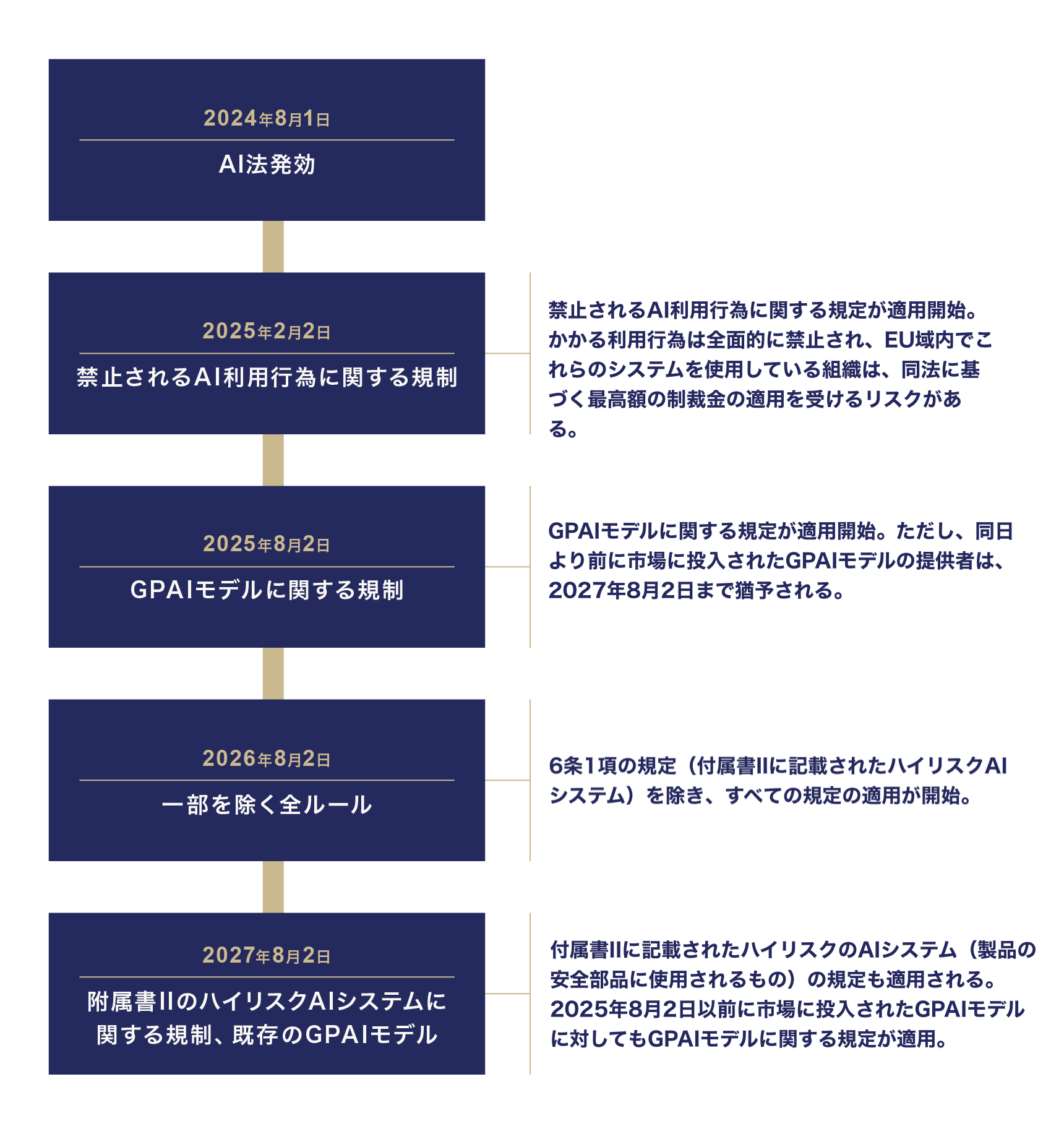

施行時期は規制内容に応じて分かれており、許容できないリスクを伴う「禁止されるAIの利用行為」に関する規制等は2025年2月2日から、GPAIモデルに関する規制等は同年8月2日から、残りの多くの規定は2026年8月2日から施行される予定です。

AI法が適用される対象は広く、EUに拠点がない日本企業にも適用される可能性があります。違反内容に応じて非常に高額な制裁金が定められている点にも注意が必要です。日本企業は、自社が開発・提供・利用するプロダクトやサービスがEU AI法の適用対象となるのか、その場合はEU AI法に基づくどのリスクに分類されるのか、そしてどのような対応を取る必要があるか、分析を進める必要があります。

本記事においては、できる限り最新の情報を踏まえてEU AI法のキーポイントを説明したうえで、全面的な適用開始に向けてどのように準備をしていけばよいのか、具体的なステップを解説します。

EU AI法とは

AI法の概要と日本企業への影響

EUにおいてAIモデル・AIシステムを規制する「European Artificial Intelligence Act」(以下「AI法」といいます)は、2024年5月21日に欧州理事会において承認された後、同年7月12日付けでEU官報に掲載され、その20日後である2024年8月1日から発効しています。なお、AI法の条文のファイナル版は、EUのウェブサイトで確認できます。

AI法は、「AIシステム」と「汎用目的AI(General Purpose AI)モデル」(以下「GPAIモデル」といいます)を規制対象としています。

特に前者に関しては、リスクベースアプローチに基づき「AIシステム」を4つのカテゴリに分類し、リスクが高いAIシステムにより厳格な要件を定めています。このリスクカテゴリごとに、また、AIシステムのバリューチェーンにおける事業者の役割(提供者、ディプロイヤー、輸入業者、販売業者等)ごとに、異なる義務が適用されます。

- 許容できないリスク(Unacceptable risk)

- ハイリスク(High risk)

- 透明性のリスク(Specific transparency risk)

- 最小リスク(Minimal risk)

AI法が適用される対象は広く、EUに拠点がない日本企業であっても適用される可能性があります。日本企業においても、自社が開発・提供・利用するプロダクトやサービスがAI 法の適用対象となるのか、その場合はAI法に基づくどのリスクカテゴリに分類されるのか、そしてどのような対応の必要があるか、分析を進める必要があります(具体的なアプローチやポイントは6以降を参照)。

AI法の施行時期

AI法の施行時期は、規制内容に応じて分かれています。禁止されるAIの利用行為に関する規制等は2025年2月2日から、GPAIモデルに関する規制等は同年8月2日から、残りの多くの規定は2026年8月2日から適用が開始することになります。

施行のタイムライン

重要な規定の解釈に関わるガイドライン

AI法の条文には不明確な文言も多く残されています。今後、欧州委員会は、AI法の重要な規定の解釈に関わるガイドラインを公表することが予定されています。

欧州委員会がガイドラインを策定することとされている事項としては、たとえば以下のものがあります。AIシステムの定義、禁止されるAI利用行為に関するガイドラインは2025年1月までに公表される見込みですが、その他のガイドラインについては現時点では具体的な公表時期は未確定です。

公表が予定されているガイドライン

| ガイドラインの内容 | 公表時期(見込み) |

|---|---|

|

未確定 |

|

〜2025年1月 |

|

未確定 |

|

未確定 |

|

未確定 |

|

〜2025年1月 |

|

未確定 |

|

未確定 |

AI法の罰則

AI法は、規制への違反に関して制裁金を定めています。違反内容に応じて非常に高額な制裁金が定められている点に注意が必要です。

| 違反類型 | 制裁金 | 関連条文 |

|---|---|---|

| 「許容できないリスク」のある AIシステムの禁止に対する違反 |

前会計年度における世界全体における売上総額の7%か、3,500万ユーロのいずれか高い金額が上限 | 99条3項 |

| その他の所定の義務に対する違反 | 前会計年度における世界全体における売上総額の3%か、1,500万ユーロのいずれか高い金額が上限 | 99条4項、101条1項 |

| 監督機関の要請に対する、不正確、不完全または誤解を招く情報の提供 | 前会計年度における世界全体における売上総額の1%か、750万ユーロのいずれか高い金額が上限 | 99条5項 |

AI法の規制対象の「AIシステム」と「GPAIモデル」

AI法は、「AIシステム」と「GPAIモデル」を規制対象としています。

AIシステムについては、リスクに応じた規制が設けられています。一方で、GPAIモデル以外のAIモデルについては、一般的な定義も具体的規制もないため、多くのAIモデル(NLPモデル 1 など)は特に規制されていません。

AIモデルは、AIシステムの重要な構成要素となる場合も多いですが、AIモデルそれ自体はAIシステムとはなりません(前文97項)。AIモデルは、大量のデータを使って訓練されたアルゴリズム等のモデル自体を指します。AIモデルの例としては、OpenAIのGPT-4oがあります。

AIモデルは、ユーザーインターフェースなどの追加要素を加えることで、AIシステムとなります。たとえば、OpenAI社のChatGPTのアプリはAIシステムであり、GPT-4oはそのAIシステムを動かすAIモデルということなります。

AI法は、基本的には、AIモデルそのものを規制するものではなく、AIモデルを包含する、あるいは、AIモデルに基づいて構築されたAIシステムを規制対象とするものです。ただし、例外的に、「GPAIモデル」と「システミックリスクを有するGPAIモデル」に関しては特別な規制を設けています(「GPAIシステム」に適用する特別な規制を設けるものではありません)。

AIシステム

(1)定義

AI法は「AIシステム」を規制しているという点で、安全なAIシステムやモデルをEU市場に投入することを促進することを目的とした製品安全規制といえます。

AI法は、「AI」を定義せず、「AIシステム」を以下のとおり定義しています(下線は筆者)。

さまざまなレベルの自律性で動作するように設計され、ディプロイ後に適応性を示すことができる機械ベースのシステムであって、明示的または暗黙的な目的のために、受信した入力から、物理的または仮想的な環境に影響を与えることができる出力(予測、コンテンツ、推奨または決定など)を生成する方法を推論するものをいう。

少し分かりづらい定義ですが、AIシステムは、主に、①機械ベース、②自律性のレベル、③適応力、④明示的または暗黙的な目的、⑤環境(物理的または仮想的な環境で動作する)、⑥推論する能力という特徴があります。

AI法は、AIシステムの推論する能力を強調しています(前文12項)。また、自律性は、AIを従来のソフトウェアから切り離すものとして重要であると考えられます。つまり、単に人間が定めたルールに従って計算処理をするといったものは該当せず、人間からある程度独立し、人間の介入なしに動作する能力を持つことが想定されます。

ただし、どの程度の推論能力や自律性が必要とされるかは現時点では明らかではなく、今後公表されるガイドラインにおいてより詳細なガイダンスが提供される見込みです。

(2)具体例

AIシステムの例としては、以下のものが挙げられます。もっとも、「AI」との名前が付いているものであっても、実際は単にルールベースでの計算処理を行うものなど、AI法上「AIシステム」に該当するものではないものも含まれるため、具体的なシステムごとに、個別に判断することが必要となります。

- 自動運転などのAIシステム

- AIチャットボット

- AIアシスタント

- 従業員のモニタリングAI

- 画像・動画の生成AI

一方、AI法には適用除外も設けられています。たとえば、科学的研究開発のみを目的とするAIシステムや、オープンソースのAIシステムは、適用が除外されます。

汎用目的AIモデル(GPAIモデル)

(1)定義

AI法には、AIシステムに加えて、GPAIモデルに関する規制があります。当初のAI法の草案においてはこのような規制は含まれていませんでしたが、ChatGPTなどの生成AIの利用が急速に広まったことから、立法過程において新たに規制が追加されることとなりました。GPAIモデルに関する規制は、GPAIモデルがAIシステムに統合されたとしても、AIシステムに関する規定に加えて、適用されます。

AI法は、GPAIモデルを以下のように定義しています。

大量のデータを使用して、自己教師にて大規模に訓練された場合を含め、顕著な汎用性を示し、モデルが市場に投入される方法にかかわりなく、広範囲の異なるタスクを適切に実行でき、さまざまな下流のシステムやアプリケーションに統合できるAIモデルをいう。ただし、市場に投入される前の研究、開発、またはプロトタイピング活動に使用されるAIモデルはGPAIから除く。

GPAIモデルの重要な特徴としては、汎用性と、広範囲の異なるタスクを適切に実行できる能力が挙げられます。

汎用性の判断にあたっては、特にパラメータの数は考慮要素の1つであり、少なくとも10億のパラメータ(モデルが学習中に学習する変数)を有し、大規模な自己教師の方法によって大量のデータで学習されたモデルは、顕著な汎用性を示し、広範囲の異なるタスクを適切に実行できる能力があるとされています(前文98項)。

(2)具体例

AI法は、テキスト、音声、画像または映像の形でコンテンツを柔軟に生成でき、広範囲で特徴的なタスクに容易に対応できる生成AIは、GPAIモデルの典型例であるとしています(前文99項)。GPAIモデルの代表例としては、以下のものが挙げられます。

- DALL-EやStable Diffusionのような画像ジェネレーター

- GPT-4、Claude、Google's Bard、LLaMaのような大規模言語モデル

- Elevenlabs、OpenAI Jukeboxのような音声ジェネレーター

AI法の適用対象者の「事業者」の類型

事業者の類型と定義

AI法では、同法で定められた規制を遵守する責任がある主体として以下の類型を定義し、さらに、これらを総称して「事業者(operator)」と定義しています(3条8号)

自社がどの事業者に該当するのかを理解することは、AI法の義務の遵守を確保し、関連するリスクを管理するために重要です。そのため、事業者がAI関連のプロジェクトを開始する際には、当初から、その目的と関係当事者の役割を明確に定め、バリューチェーン全体に適用する義務を特定することが重要といえます。

| 提供者 (provider) |

AIシステムまたはGPAIモデルを自ら開発しもしくは開発をさせ、それを市場に出すかもしくは自らの名前・商標の下でサービスを提供する自然人、法人、公的機関、機関その他の団体を指し、有償か無償かを問わない。 |

| ディプロイヤー (deployer) |

自らの権限でAIシステムを利用する自然人または法人、公的機関、機関その他の団体を指す。※個人的な非業務活動の過程でAIシステムを利用する場合は除外される。 |

| 輸入業者 (importer) |

第三国に設立された自然人または法人の名称または商標を付したAI システムを市場に投入する、EU 域内に所在しまたは設立された自然人もしくは法人。 |

| 販売業者 (distributor) |

提供者または輸入業者以外のサプライチェーンの自然人または法人であって、AI システムを欧州市場で利用可能にするもの。 |

| 製品製造者 (product manufacturer) |

付属書Iに列挙された各法令の定義に従う(前文87項)。 |

AI法では、特にハイリスクAIシステムを扱う場合に、一連の具体的な義務を負うことになる提供者とディプロイヤーの概念が重要です。顧客サービス、文書作成・管理、不正防止、従業員モニタリングのためにサードパーティ製のAIシステムを使用している企業は、一般的にディプロイヤーに該当し得ます。

AI法が適用される対象者(域外適用を含む)

AI法は、同法の適用対象者を、以下のとおり定めています(2条1項、下線は筆者)。

事業者の所在地にかかわらず、EU域内の個人に影響を与えるすべてのAIシステムおよびGPAIモデルを規制の対象とするため、EU域内に拠点の設立されていない日本企業にも適用される場面も多く想定され、注意が必要です。

(a)域内で、AI システムを市場に投入、サービスに供する、または汎用目的AI モデルを市場に投入する提供者。EU 域内において設立または所在しているか否かにかかわらない。

(b)EU域内に設立されているまたは所在する、AI システムのディプロイヤー

(c)EU域外に設立または所在する、AI システムの提供者とディプロイヤーであって、当該AI システムによって生成された出力結果(アウトプット)がEU 域内で使用される場合

(d)AI システムの輸入業者または販売業者

(e)AI システムを、自社製品とともに、自己の名称または商標で、市場に投入するまたはサービスに供する製品製造業者

(f) EU域内に設立されていない提供者の認定代理人

(g)EU域内に所在する、影響を受ける者

AI法が域外適用される場面としては、まず、EU域外のAIシステム・GPAIモデルの提供者が、EU域内で当該システム・モデルを市場に投入し、サービス提供を開始した場合が考えられます。

たとえば、EU域内に拠点を持たない日本企業がAIシステムを開発し、EU域内で使用するために顧客に提供する場合には、その提供者としてAI法が適用されます。

また、AIシステムのアウトプットがEU域内で使用される場合、AIシステムのEU域外の提供者やディプロイヤーにもAI法が適用されます。この趣旨は、EU域内の事業者が、AI関連業務をEU域外にアウトソーシングし、そのアウトプットをEU域内で使用することによって、意図的にAI法の適用を回避することを防止する点にあります。

たとえば、EU域内の事業者がEU域内で求人の応募を受け、それを日本の事業者に送り、日本の事業者が自らのAIシステムを使用して応募者を選別し、その結果をEU域内の事業者にフィードバックし、当該情報に基づいて採用を決定するような場合、当該日本の事業者は、AIシステムの提供者としてAI法が適用されます。

なお、ハイリスクAIシステムの提供者がEU域外に設立されている場合、EU域内の認定代理人(authorised representative)を任命しなければなりません(後述4-2(2)を参照)。

AIシステムに対する規制の概要

AI法は、リスクベースアプローチの観点から、AIシステムに関するリスクを4つのカテゴリに分類し、リスクの程度に応じた義務を課しています。

リスクベースアプローチに基づくAIシステムの4つのカテゴリ

AIシステムの分類と要件に関し、大要、①「許容できないリスク」が認められるAIシステムの市場投入・サービス開始等を禁止し、②「ハイリスク」のカテゴリのAIについてはAI法が定める広範な要件を満たすことを要求し、③「透明性のリスク」がある特定のAIについては一定の開示義務を課し、④「最小リスク」については特段の規制を設けないとしています。

なお、③透明性のリスクに対応する情報開示義務は、②ハイリスクAIのAIシステムであっても重畳的に適用される場合があります。

許容できないリスクのあるAIシステムに関する規制

AI法は、AIシステムによる一定の行為を禁止しています(5条1項)。禁止対象となる行為(prohibited AI practice)は、以下のとおりで、事業者の類型を問わず適用されます。これらの禁止行為は、①人々の行為に影響を与えるAIシステムによるものと(下表1、2)、②AIシステムによる人の分類(下表の3~7)、③法施行目的でのリアルタイム遠隔性認証(下表の8)に大別できます。なお、第5条で禁止される行為のリストは、毎年、欧州委員会がその修正の必要性を評価することが予定され(112条)、いずれ変更が加えられる可能性があります。

禁止されるAI利用行為

| 1. | 潜在意識(サブリミナル)操作技術の使用 | 潜在意識を超えた技術や意図的に操作的または欺瞞的な技術を使用し、人々の行動を著しく歪め、情報に基づいた決定を下す能力を損なわせるAIシステムの市場投入、サービス開始、使用。 |

| 2. | 脆弱性の悪用 | 年齢、障害、特定の社会的または経済的状況に基づく脆弱性を悪用し、人々の行動を著しく歪めるAIシステムの市場投入、サービス開始、使用。 |

| 3. | ソーシャルスコアリング | 社会的行動や個人の特性に基づいて人々を評価または分類し、不利な扱いを引き起こすAIシステムの市場投入、サービス開始、使用。 |

| 4. | 犯罪プロファイリング | プロファイリングや個人の特性に基づいて犯罪リスクを評価するAIシステムの市場投入、サービス開始、使用。 ※ただし、客観的かつ検証可能な事実に基づく人間による評価を支援するAIシステムは除く。 |

| 5. | 顔認識データベースの作成 | インターネットや防犯カメラ映像から無差別に顔画像を収集して顔認識データベースを作成するAIシステムの市場投入、サービス開始、使用。 |

| 6. | 感情推測 | 職場や教育機関での感情推測を行うAIシステムの市場投入、サービス開始、使用。 ※ただし、医療や安全目的での使用は除く。 |

| 7. | 生体データに基づくセンシティブな分類の推測 | 生体データに基づいて人種、政治的意見、労働組合の加入、宗教や哲学的思想、性生活や性的指向を推測するAIシステムの市場投入、サービス開始、使用。 ※ただし、法執行分野で合法的に取得された生体データのラベリングやフィルタリングは除く。 |

| 8. | 法執行目的でのリアルタイムの遠隔生体識別 | 公共の場での法執行目的でのリアルタイムの遠隔生体認証システムの使用。 ※ただし、特定の被害者の捜索、生命や身体の安全に対する差し迫った脅威の防止、一定の犯罪捜査や刑罰の執行のための使用は除く。 |

潜在意識の操作技術の使用や感情推測などの要件は、必ずしも適用範囲が明確ではなく、今後ガイドラインにおいてより明確化されることが予定されています。

ハイリスクAIシステムに関する規制

(1) ハイリスクAIシステムとは

AI法は、人々の健康、安全、基本的権利に重大な影響をもたらす可能性が高い一定のAIシステムを「ハイリスクAIシステム」に分類し、関連する事業者に広範な義務を課しています。

ハイリスクAIシステムには、以下の2つの類型があります。下記②の付属書IIIに記載されたハイリスクAIシステムは、意思決定の結果に重大な影響を与えないなど、実質的に自然人の健康、安全、または基本的権利に対して重大な危害のリスクをもたらさない場合は、例外的に、ハイリスクAIとして扱われません。ただし、個人のプロファイリングを含むAIシステムは、常にハイリスクとみなされます(6条3項)。

ハイリスクAIシステムの2つの類型

| ① 付属書Ⅰ関係 |

自動車やその部品等、EU法令上、一定の製品安全に関する規制の対象となっている製品等に関して、安全コンポーネントとして使用されるAIシステム |

|---|---|

| ② 付属書Ⅲ関係 | 特定のユースケース※に該当するハイリスクAIシステム |

※具体的には、(1)バイオメトリクス、(2)重要インフラ、(3)教育と職業制度、(4)雇用、労働者管理、事業者へのアクセス、(5)不可欠な民間サービスや公共サービス、公共給付へのアクセスと享受、(6)法執行、(7)移民、難民、国境管理、(8)司法と民主的プロセス。

上記2類型の定義および具体例については、下記の関連記事をご参照ください。

(2)ハイリスクAIシステムの提供者の義務

- 16条が規定する義務

AI法は、ハイリスクAIシステムの提供者に対して、以下の義務を課しています。同義務を規定しているのは16条ですが、同条では他の条文を参照している箇所も多く、全体像を把握するには参照されている各条文も確認することが必要となります。

| 16条に規定されている提供者の義務 | 関連条文 | |

|---|---|---|

| (a)システム要件の遵守 | ハイリスクAIシステムがシステム要件に適合していることを確保する。 | 8条から15条 |

| (b)表示義務 | ハイリスクAIシステム、またはそれが不可能な場合はその包装や付属文書に、提供者の名前、登録商号または登録商標、連絡先住所を表示する。 | − |

| (c)品質管理システム | 品質管理システムを導入する。 | 17条 |

| (d)文書の保持 | 技術文書、品質マネジメントシステム関連文書、EU適合宣言書等を保持する。 | 18条 |

| (e)ログの保持 | 提供者の管理下にあるハイリスクAIシステムによって自動生成されたログを保持する。 | 19条 |

| (f)適合性評価 | ハイリスクAIシステムを市場投入する前またはサービスの開始前に、適合性評価手続を受ける。 | 43条 |

| (g)EU適合宣言 | EU適合宣言を作成する。 | 47条 |

| (h)CEマーキング | AI法に適合していることを示すために、ハイリスクAIシステム、またはそれが不可能な場合はその包装や付属文書にCEマーキング 2 を付ける。 | 48条 |

| (i)登録義務 | 市場投入する前またはサービス開始前のEUデータベースへの登録義務を遵守する。 | 49条1項 |

| (j)是正措置 | ハイリスクAIシステムの要件を遵守していない場合等において、必要な是正措置を講じ、情報を提供する。 | 20条 |

| (k)適合性の証明 | 国の権限ある当局の合理的な要求に応じて、ハイリスクAIシステムがシステム要件に適合していることを証明する。 | Section 2 |

| (l)アクセシビリティ要件 | 製品・サービス・公共機関のウェブサイト・モバイルアプリについて、ハイリスクAIシステムがアクセシビリティ要件に適合していることを保証する。 | 指令(EU) 2016/2102 および(EU) 2019/882 |

また、ハイリスクAIの提供者に対して課される義務は、16条において規定されている義務のほかにもさまざまなものがあります。特に留意すべき義務として、認定代理人の選任と重大なインシデントの報告義務が挙げられます。

- 認定代理人の選任

EU域外に拠点を置く提供者は、ハイリスクAIシステムをEU市場に投入したり、サービス提供を開始する前に、EU内の認定代理人(authorised representative)を文書による委任状で任命しなければなりません(22条1項)。

認定代理人は、たとえば、EU適合宣言書等の作成や適合性評価手続の実施を確保し、また、規制当局とのやり取りにおいて提供者を代表することになります。EU域内に拠点を持っていない日本企業においては、認定代理人の選任を行う必要があり、適切な認定代理人の選定を行うにあたっては一定程度時間がかかる可能性があるため、留意が必要です。 - 重大なインシデントの報告義務

ハイリスクAIシステムの提供者は、重大なインシデントが発生した場合、当該インシデントが発生した加盟国の市場監視当局に対して報告義務を負います。報告は、ハイリスクAIシステムとインシデントとの間に因果関係またはその合理的な可能性が確認された後、直ちに行う必要があります(73条2項)。

また、提供者は、インシデントの後にリスク評価を実施し、適切な是正措置を講じる必要があります(73条6項)。

(3)ハイリスクAIシステムのディプロイヤーの義務

- 26条が規定する義務

AI法は、ハイリスクAIシステムのディプロイヤーに対して以下の義務を課しています(26条)。

| 要件 | 詳細 |

|---|---|

| 使用説明書に従った技術的・組織的措置 | システムの使用説明書に従って適切な技術的および組織的措置を講じる。 |

| 人間の監視 | 必要な能力、訓練、権限を持つ自然人に人的監視を割り当てる。 |

| 入力データの管理 | ディプロイヤーが入力データを管理する場合、そのデータが目的に対して適切であることを確認する。 |

| システムの監視 | 使用説明書に基づいてシステムの運用を監視し、リスクがある場合は提供者や市場監視当局に通知し、使用を中止する。 |

| ログの保持 | システムが自動生成するログを少なくとも6か月間保持する。 |

| 労働者への通知 | ディプロイヤーが雇用主である場合、職場でハイリスクAIシステムを使用する前に労働者代表および影響を受ける労働者に通知する。 |

| 公的機関の登録義務 | 公的機関のディプロイヤーは、EUデータベースに登録されていないシステムを使用しないようにし、提供者または販売業者に通知する。 |

| データ保護影響評価 | データ保護影響評価を実施するために必要な情報を使用する。 |

| 司法当局の承認 | 犯罪捜査のためにハイリスクAIシステムを使用する場合、事前または48時間以内に司法当局の承認を得る。 |

| 自然人への通知 | ハイリスクAIシステムが自然人に関する決定を行う場合、その使用について自然人に通知する。 |

| 当局との協力 | 関連当局がこの規則を実施するために取る行動に協力する。 |

- ハイリスクAIの基本的権利への影響評価

26条が規定する義務に加えて、ディプロイヤーのうち、行政機関や公共サービスを提供する民間企業、クレジットスコア 3 を設けるためのAIシステムを利用する事業者、生命保険等におけるリスクアセスメントのためのAIシステムを利用する事業者などにおいては、ハイリスクAIの基本的権利への影響評価を行うことが求められています(27条1項)。 - 提供者の義務が課される場合

自社が、提供者なのかディプロイヤーなのかを理解することは、AI法上の義務の遵守を確保し、関連するリスクを管理するために重要です。ただ、AI法での提供者とディプロイヤーの区別は必ずしも明確ではなく、ディプロイヤーは、以下のような特定の場面においては提供者にも該当し、提供者に関する義務が適用されることに留意する必要があります。

- ハイリスクAIシステムに自社の名称や商標をつける

AIシステムを自社でリブランディングする場合等は留意が必要。 - ハイリスクAIシステムに重大な変更を加える

AIシステムが「重大な変更」される場合として、AIシステムの意図された目的が変更される場合が考えられる。 - GPAIシステムの目的を変更する

ディプロイヤーが、さまざまな用途に使用できるGPAIシステムを、教育や人事といったリスクの高い用途に特化したシステムとして再利用する場合が考えられる。

透明性のリスクのあるAIシステムに関する規制

AIチャットボットなど一定の類型のAIシステムについては、たとえば、AIとやり取りしていることをユーザーが認識できるようにするなど、提供者とディプロイヤーに対して一定の透明性の義務が課せられています(50条)。

なお、ハイリスクAIシステムについても、当該類型に当てはまる場合には、透明性の義務が重畳的に課されることとなります。

| 対象となるAIシステム | 例 | 提供者もしくはディプロイヤーの義務内容 |

|---|---|---|

| 自然人と相互作用することを意図されたAIシステム | 対話型AI | 【提供者】

|

| 人工音声、画像、動画、テキストなどのコンテンツを生成するAIシステム | 画像生成AI | 【提供者】

|

| 感情認識または生体分類に用いられるAIシステム | 感情認識AI 性別判定AIカメラ |

【ディプロイヤー】

|

汎用目的AIモデル(GPAIモデル)に対する規制の概要

AI法においては、上述4のAIシステムに関する規制に加えて、GPAIモデルに関する規制があります。当初のAI法の草案においてはこのような規制は含まれていませんでしたが、ChatGPTなどの生成AIの利用が急速に広まったことから、立法過程において新たに規制が追加されることとなりました。

GPAIモデルの提供者の義務

AI法は、GPAIモデルの提供者が負う義務として、主に以下の内容を定めています(53条)。

| 義務内容 | 詳細 |

|---|---|

| 技術文書の作成と更新 | モデルの技術文書を作成し、最新の状態に保ち、AIオフィスや国内の権限当局に提供できるようにする。 |

| 情報と文書の提供 | GPAIモデルを統合しようとするAIシステムの提供者に対して、情報と文書を提供し、理解を助ける。 |

| 著作権法の遵守 | 著作権および関連権に関するEU法を遵守するための方針を策定し、最新技術を用いて権利の留保を特定し遵守する。 |

| トレーニング内容の公開 | GPAIモデルのトレーニングに使用された内容について、AIオフィスが提供するテンプレートに従って詳細な要約を公開する。 |

また、GPAIモデルの提供者が、EU域外に拠点を置く場合、ハイリスクAIシステムの提供者と同様、認定代理人を選任する義務があります(54条)。ただし、ハイリスクAIシステムの提供者の認定代理人と異なり、選任義務が免除される場合があります(同条6項)。

なお、GPAIモデルの提供者がその義務を遵守できるよう、AIオフィスは、提供者がこれらの義務を遵守していることを示すために使用できる行動規範を作成する予定です。欧州委員会はGPAIに関する行動規範について、最初の草案を2024年11月14日に、第2次草案を同年12月16日に公表しており、2025年4月ごろに最終決定される予定です。

「システミックリスクを伴うGPAIモデル」の場合の追加的規制

AI法は、GPAIモデルのうち、システミックリスクを有するものを「システミックリスクを伴うGPAIモデル」と定義し、追加的な規制を課しています。

(1)システミックリスクを伴うGPAIモデルとは

システミックリスクとは、GPAIモデルの高い影響力に特有のリスクを意味し、その影響力の大きさや、公共の健康、安全、公的な安全、基本的権利、または社会全体に対する実際のまたは合理的に予見可能な負の影響により、EU市場に重大な影響を与えるリスクであり、バリューチェーン全体に大規模に伝播する可能性があるものを指します(3条65号)。

システミックリスクの有無は、当該モデルの能力等から判断されますが、モデルの訓練のために使用された計算量が浮動小数点演算で10の25乗を超える場合には、システミックリスクを有するものと推定されます(51条2項)。

(2)システミックリスクを伴うGPAIモデルの提供者の義務

GPAIモデルの提供者は、システミックリスクを伴うGPAIモデルの要件に該当することを認識してから2週間以内に欧州委員会に通知する義務を負っています(52条1項)。

そして、システミックリスクを伴うGPAIモデルの提供者には、以下の追加的な義務が課されることとなります。

| 義務内容 | 詳細 |

|---|---|

| モデル評価 | 標準化されたプロトコルとツールに従ってモデル評価を実施し、システムリスクを特定し軽減するための対策を文書化する。 |

| リスク評価と軽減 | AIモデルの開発、市場投入、使用に伴うシステムリスクを評価し、軽減する。 |

| 重大事故の報告 | 重大事故や是正措置に関する情報をAIオフィスおよび適切な国家当局に遅滞なく報告する。 |

| サイバーセキュリティ | システミックリスクを伴う汎用目的AIモデルとその物理インフラに対して適切なレベルのサイバーセキュリティ保護を確保する。 |

日本企業における実務上の対応ポイント

これまで見てきたとおり、AI法の規制対象は広く、また、適用される場合におけるコンプライアンスの対応はかなり重い負担となります。それでは、日本企業はどこから手をつけていくべきでしょうか。

AIマッピング:自社が開発・提供・利用するAIを特定する

まず、AIマッピングを実施し、自社内でどのようなAIが利用されているか、AIを利用したサービスを提供しているかを把握することから始める必要があります。

そのうえで、使用されているAIが「AIシステム」または「GPAIモデル」に該当するかどうかを判断する必要があります。現在、AIと名称が付いたサービスであっても、実際にはAI法の規制対象とするような自律性を有していない場合もあります。

EUに拠点を持たない日本企業においては域外適用の分析

AI法は、EU域内に拠点を設立していない場合であっても適用される可能性があります(上述3-2を参照)。自社が開発・提供・利用するAIシステムが、AI法の域外適用の対象となるのか、評価を行うことになります。

AIシステムのリスクカテゴリを評価する

AI法が適用されるスコープ内のAIシステムについて、そのAIシステムがどのリスクカテゴリに分類されるのかを分析する必要があります。ハイリスクAIシステムに該当するのか、透明性義務が課されるのか、あるいは、AI法の義務が課されない最小リスクのAIの利用にとどまるのかを分析をする必要があります。

自社の事業者カテゴリを判断する

そのうえで、自社が提供者なのか、ディプロイヤーなのか、輸入業者なのか、販売業者なのか等を判断し、AI法により適用される義務を特定する必要があります。

AIガバナンスの設計と開発

自社の事業者カテゴリを特定した後は、AI法上各事業者に課された義務の内容と、現状の運用を照らし合わせて、ギャップがある部分を特定し、対応すべき事項をリストアップすることが考えられます。もっとも、一度にすべての規定に対応することが難しい場合も想定され、その場合はAI法の適用開始のタイムライン、リスクの大きさ、コストの大きさなどを考慮しつつ、優先順位をつけて対処する計画を関係部署と協力して策定する必要があります。

検討事項としては、たとえば以下のようなものが考えられます。

- どのチームが関与する必要があるか

- どのようなポリシー、プロセス、文書が必要か

- 既存のガバナンス慣行(プライバシーなど)から構築できるか

- 技術的なギャップや知識のギャップを埋めるには何が必要か

- どのような種類の追加ツールが必要か など

実務上よくある質問(Q&A)

AI法の適用関係について疑問をお持ちの方も多いと思います。以下、よくある質問をQ&A形式でまとめます。

日本企業が自社のウェブサイトを利用して、AIシステムをEUのユーザーに提供している場合、この企業はEU市場にAIシステムをサービスに供しているため、AI法が適用されます(上述3-2を参照)。たとえば、このAIシステムがハイリスクAIに該当するものである場合、ハイリスクAIの提供者としての義務を負います(上述4-2を参照)。

また、たとえば、EUのユーザーにも提供しているウェブサービスにおいて、EUのユーザーのヘルプセンターとして、チャットボットを使用する場合、AI法に基づく透明性義務についての対応も必要となります(上述4-3を参照)。

この例では、EU域内の親会社がAIシステムのディプロイヤーとしてAI法が適用されることになると考えられます。そのため、そのAIシステムがAI法に基づいて規制されるリスクカテゴリに該当する限り(許容できないリスク、ハイリスク、透明性のリスクなど)、EU域内の親会社は、当該リスクカテゴリのディプロイヤーとしての義務を負います。

他方で、日本の子会社は、そのAIシステムによって分析されたデータを利用するだけであれば、AI法の適用はなく、規制を受けないものと考えられます。

AI法は、適用対象となる事業者を分類し、事業者ごとに異なる義務を定めていますが、その大部分は提供者に課せられます。ある事業者が、AIシステムを開発せず、あくまで他の提供者によって提供されるAIシステムを利用するだけの場合、少なくとも、ディプロイヤーに該当する可能性はありますが、原則として、提供者としての義務を負うものではありません。

ただし、一定の場合には、他の事業者のAIシステムをベースに利用する場合であっても、提供者としての義務を負う場合があるので、留意が必要です(上述4-2(3)を参照)。

AI法はBtoBだけでなくBtoCにも適用されます。また、採用人事の応募者の評価を支援するAIツールは、ハイリスクAIに該当し得るものです(上述4-2(1)を参照)。この例では、ハイリスクAIの提供者としてAI法が適用されることになると考えられます(上述4-2(2)を参照)。

BtoBにおいては、AIシステムの提供者とディプロイヤーが異なる事業者であることがあります。たとえば、HRサービス会社が、応募者の評価を支援するAIツールを提供しており、EU域内の事業者が応募者の選考とテストのために当該AIツールを使用する場合は、当該事業者はディプロイヤーに該当し得、ハイリスクAIシステムのディプロイヤーとしての義務を負います(上述4-2(3)を参照)。

提供者としては、たとえば、AIにおける人種や性別によるバイアスを減らし、公平で差別のない意思決定につながるよう、AIシステムを目的に適合し、かつ技術的に堅牢なものにする必要があります。また、そうしたリスクを最小限に抑え、適切に対処できるようにするため、十分に代表的なデータセットを用いてトレーニングとテストを行う必要があります。さらに、事後的な監査が可能となるよう、アルゴリズムの訓練に使用されたデータを含む適切な文書が保管されていること、また、市場に投入される前後において、このAIシステムが定期的に監視され、潜在的なリスクが迅速に対処されることを保証する必要があると考えられます。

森・濱田松本法律事務所外国法共同事業

森・濱田松本法律事務所外国法共同事業