EU AI法のハイリスクAIとは?具体例と事業者の義務を解説

IT・情報セキュリティ当社のプロダクトが、EU AI法の規制する「ハイリスクAIシステム」に該当するかを検討しています。EU AI法がハイリスクAIシステムの該当性についてどのように規定しているか、また、該当する場合の規制内容について教えてください。

EU AI法は、人々の健康、安全、基本的権利に重大な影響をもたらす可能性が高い一定のAIシステムを「ハイリスクAIシステム」に分類し、関連する事業者に、システム要件の遵守や適合性評価手続といった広範な義務を課しています。

ハイリスクAIシステムに該当するものは、①自動車やその部品等、EU法令上、一定の製品安全に関する規制の対象となっている製品等に関して、安全コンポーネントとして使用されるAIシステムと、②バイオメトリクスや重要インフラなどの特定のユースケースに該当するハイリスクAIという2つの類型に分かれます。

事業者は、自社のプロダクトやサービスがこれら2類型に該当するか否か、また自社が提供者、ディプロイヤー、輸入業者、販売業者等のいずれに該当するのかを判断し、適用される義務を特定する必要があります。

解説

目次

EU AI法におけるAIシステムの位置付け

EUにおいてAIモデル・AIシステムを規制する「European Artificial Intelligence Act」(以下「AI法」といいます)が、2024年8月1日に発効し、一部を除くほぼ全てのルールは2026年8月2日までに適用が開始されます。同法が適用される対象は広く、EUに拠点がない日本企業であっても適用される可能性があります。なお、AI法の条文のファイナル版は、EUのウェブサイトで確認できます。

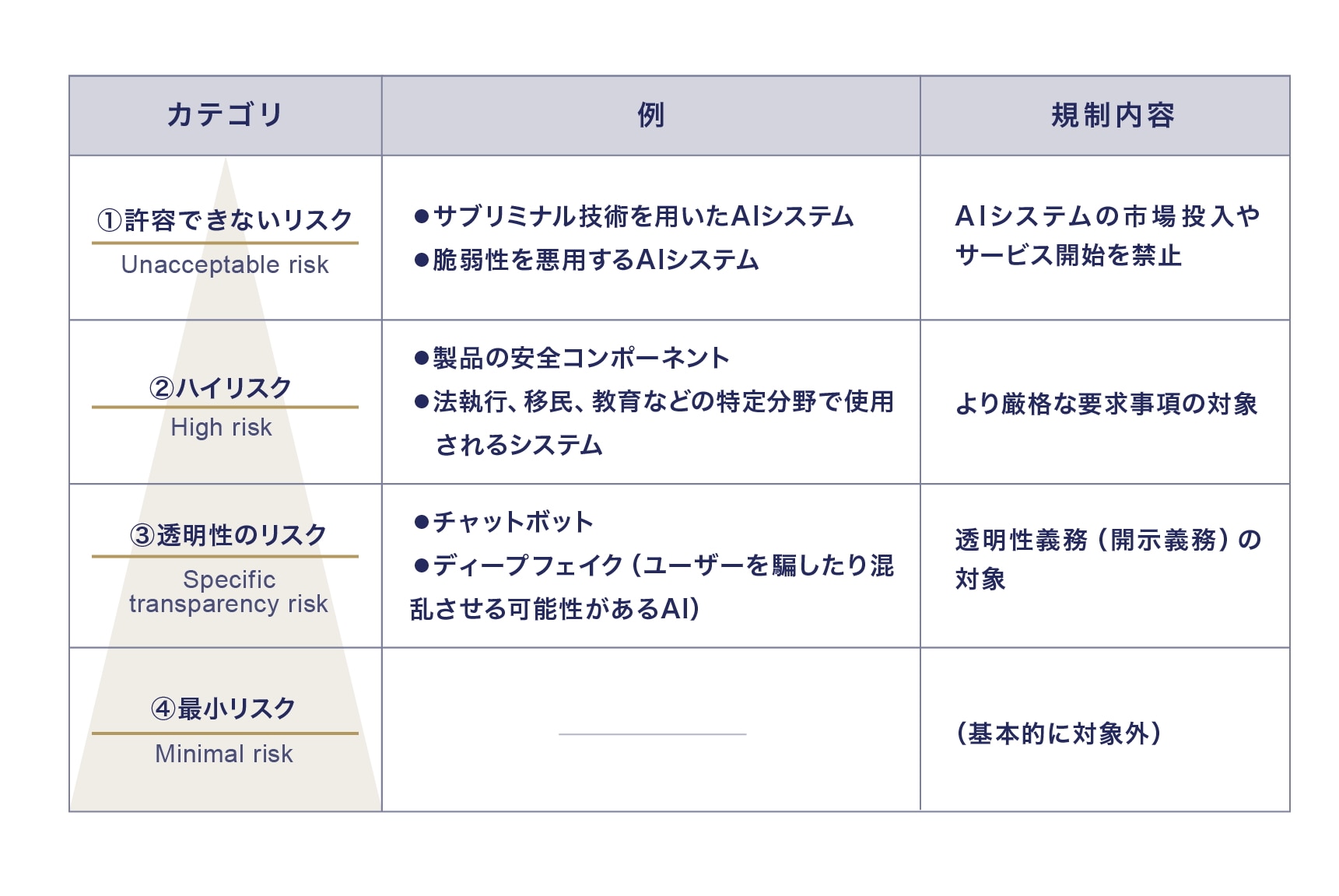

EU AI法は、「AIシステム」と「汎用目的AI(General Purpose AI)モデル」を規制対象としています。前者は4つのリスクカテゴリに分類されており、中でも「ハイリスクAIシステム」は記述が詳細で、これに該当すると判断されたAIシステムの提供者およびディプロイヤーには、より厳格な義務が課されます。

AI法の詳しい内容は、下記の関連記事をご参照ください。

AIシステムの4つのカテゴリ

AI法は、リスクベースアプローチの観点から、「AIシステム」に関するリスクを4つのカテゴリに分類し、リスクの程度に応じた義務を課しています。

リスクベースアプローチに基づくAIシステムの4つのカテゴリ

ハイリスクAIシステムとは

AI法は、人々の健康、安全、基本的権利に重大な影響をもたらす可能性が高い一定のAIシステムを「ハイリスクAIシステム」に分類し、関連する事業者に広範な義務を課しています。

ハイリスクAIシステムには、以下の2つの類型があります。

類型①:EU整合法令(Union harmonisation legislation)で規制された製品の安全コンポーネントたるハイリスクAI(付属書Ⅰ関係)

類型②:特定のユースケースに該当するハイリスクAI(付属書Ⅲ関係)

EU法令で規制された製品の安全コンポーネントたるハイリスクAI

以下の(a)および(b)の要件をいずれも満たしたAIシステムは、上述の類型①に該当し、ハイリスクAIシステムとみなされます(6条1項)。たとえば、自動車やその部品等、EU法令上、一定の製品安全に関する規制の対象となっている製品等に関して、AIシステムが安全コンポーネントとして使用される場合などがこれに該当します。

この類型①は、対象製品に該当するセクターの事業者が対象となります。

(a)AIシステムが、付属書Iに掲げられたEUの整合法令によって規制される製品の安全コンポーネントとして使用されることを目的としているか、またはAIシステム自体が付属書Iに掲げられたEUの調和立法によって規制される製品であること。

(b)AIシステムが、(a)に規定される安全コンポーネントである製品、またはAIシステム自体が製品である場合、付属書Iに掲げられたEUの調和立法によって、その製品が市場に投入されるか、または使用される前に、第三者による適合性評価を受けることが必要であること。

付属書Iに記載されているEU整合法令は、以下に関するものです。

- 機械

- 玩具の安全

- レクリエーションクラフトおよび個人用水上クラフト

- エレベーターおよびその安全コンポーネント

- 潜在的に爆発性のある環境で使用する機器・保護システム

- 無線機器

- 圧力機器

- ケーブルウェイ設備

- 個人用保護具

- ガス燃焼機器規則

- 医療機器

- 体外診断用医療機器

- 民間航空の安全

- 二輪・三輪・四輪車両

- 農業・森林業用車両

- 海上機器

- 鉄道システムの相互運用性

- 自動車および部品等

- 自動車の型式承認

- 民間航空の安全

特定のユースケースに該当するハイリスクAI

以下の付属書IIIに規定されるAIシステムは、類型②に該当し、ハイリスクAIシステムとみなされます(6条2項)。類型①と異なり、類型②は、特定のユースケースで使用されるAIシステムが対象であり、類型①に該当するような特定のセクターの事業者であるか否かにかかわらず、より広い事業者に適用される可能性があります。すなわち、たとえば、類型①に典型的に該当するような機械や自動車の部品メーカーなどでなくても、自社の採用や人事評価にAIシステムを使用する場合、バイオメトリクスを利用したAIシステムを利用する場合などがあれば、適用対象となる可能性があります。

| No. | 分野 | ハイリスクAIシステムに該当するユースケース |

|---|---|---|

| 1. | バイオメトリクス |

|

| 2. | 重要インフラ |

|

| 3. | 教育と職業訓練 |

|

| 4. | 雇用、労働者管理、自営業へのアクセス |

|

| 5. | 不可欠な民間サービスや公共サービス、公的給付へのアクセスと享受 |

|

| 6. | 法執行 |

|

| 7. | 移民、難民、国境管理 |

|

| 8. | 司法と民主的プロセス |

|

ただし、形式的には付属書IIIに規定されるAIシステムであっても、実質的に自然人の健康、安全、または基本的権利に対して重大な危害のリスクをもたらさない場合は、ハイリスクAIシステムとはみなされません。具体的には、以下の①〜④のいずれかの要件を満たす必要があります(6条3項)。

この例外規定は、ハイリスクAIシステムを市場投入等することに伴う義務やコストを回避できるため、実務上重要な役割を果たすことが期待できます。ただし、提供者は、附属書IIIに該当する自社のAIシステムが例外に該当しハイリスクではないと考える場合、当該AIシステムが市場に投入される前またはサービス提供開始前に、その評価を文書化しなければならず、当該AIシステムをEUデータベース(71条参照)に登録する等の義務が生じます(49条2項、6条4項)。

- AIシステムが、限定的な手続的なタスクを実行することを目的としていること。(例:構造化データを構造化データに変換するシステム、文書の重複を検出するシステム等)

- AIシステムが、人間が既に完了した活動の結果を改善することを目的としていること。(例:すでに作成された文書で使用される専門的な論調を改善するシステム等)

- AIシステムが、意思決定のパターンやそれからの逸脱を検出することを目的としており、人間が既に完了した評価を置き換えたり影響を与えたりすることを意図していないこと、または適切な人間によるレビューがなされること。(例:教師が適用した評定を、その教師の既存の評定パターンと比較して、矛盾や異常をチェックするシステム等)

- AIシステムが、付属書IIIに掲げられたユースケースの目的に関連する評価に先立つ準備的なタスクを実行することを目的としていること。(例:文書を翻訳するシステム等)

ただし、個人のプロファイリングを含むAIシステムは、常にハイリスクとみなされます(6条3項)。

ハイリスクAIのシステム要件

AI法は、ハイリスクAIが、Section 2(8条から15条)が定める以下のシステム要件(加えて、別途該当する場合は製品の整合規格要件)を満たすことを求めています。このハイリスクAIのシステム要件の遵守の確保は、基本的に提供者に義務付けられています(16条 (a) )。

| 要件 | 詳細 |

|---|---|

| リスク管理システム(9条) | ハイリスクAIシステムには、ライフサイクル全体を通じて継続的に計画・実行されるリスク管理システムが必要です。リスクの特定、評価、管理措置の採用が含まれます。 |

| データとデータガバナンス(10条) | トレーニング、検証、テストデータセットは、適切なデータガバナンスと管理慣行に従う必要があります。データの収集、準備、バイアスの検出と修正が含まれます。 |

| 技術文書(11条) | ハイリスクAIシステムの技術文書は、市場に出る前に作成され、最新の状態に保たれる必要があります。文書は、システムが要件を満たしていることを示し、評価のための情報を提供します。 |

| 記録保持(12条) | ハイリスクAIシステムは、システムのライフタイム中にイベントの自動記録を技術的に可能にする必要があります。 |

| 透明性と情報提供(13条) | ハイリスクAIシステムは、その運用が十分に透明であるように設計・開発される必要があります。使用説明書には、システムの特性、性能、リスク、監視措置などの情報が含まれます。 |

| 人間の監視(14条) | ハイリスクAIシステムは、使用中に自然人によって効果的に監視されるように設計・開発される必要があります。監視措置は、リスク、システムの自律性、使用状況に応じて調整されます。 |

| 精度・堅牢性・サイバーセキュリティ(15条) | ハイリスクAIシステムは、適切な精度、堅牢性、サイバーセキュリティを達成し、ライフサイクル全体で一貫して性能を発揮するように設計・開発される必要があります。 |

ハイリスクAIシステムに関して事業者に求められる対応

AI法は、ハイリスクAIシステムの提供者およびディプロイヤーに対してそれぞれ義務を課しています。

| 提供者 (provider) |

AIシステムまたはGPAIモデルを自ら開発しもしくは開発をさせ、それを市場に投入するかもしくは自らの名前・商標の下でサービスを提供する自然人、法人、公的機関、機関その他の団体を指し、有償か無償かを問わない。 |

|---|---|

| ディプロイヤー (deployer) |

自らの権限でAIシステムを利用する自然人または法人、公的機関、機関その他の団体を指す。 ※個人的な非業務活動の過程でAIシステムを利用する場合は除外される。 |

以下にハイリスクAIシステムの提供者およびディプロイヤーにおける主な義務を列挙します。

提供者に課せられる主な義務

AI法は、ハイリスクAIシステムの提供者に対して、以下の義務を課しています(16条)。

| 16条に規定されている提供者の義務 | 関連条文 | |

|---|---|---|

| (a)システム要件の遵守 | ハイリスクAIシステムがシステム要件に適合していることを確保する。 | 8条から15条 |

| (b)表示義務 | ハイリスクAIシステム、またはそれが不可能な場合はその包装や付属文書に、提供者の名前、登録商号または登録商標、連絡先住所を表示する。 | − |

| (c)品質管理システム | 品質管理システムを導入する。 | 17条 |

| (d)文書の保持 | 技術文書、品質マネジメントシステム関連文書、EU適合宣言書等を保持する。 | 18条 |

| (e)ログの保持 | 提供者の管理下にあるハイリスクAIシステムによって自動生成されたログを保持する。 | 19条 |

| (f)適合性評価 | ハイリスクAIシステムを市場投入する前またはサービスの開始前に、適合性評価手続を受ける。 | 43条 |

| (g)EU適合宣言 | EU適合宣言を作成する。 | 47条 |

| (h)CEマーキング | AI法に適合していることを示すために、ハイリスクAIシステム、またはそれが不可能な場合はその包装や付属文書にCEマーキング [^2] を付ける。 | 48条 |

| (i)登録義務 | 市場投入する前またはサービス開始前のEUデータベースへの登録義務を遵守する。 | 49条1項 |

| (j)是正措置 | ハイリスクAIシステムの要件を遵守していない場合等において、必要な是正措置を講じ、情報を提供する。 | 20条 |

| (k)適合性の証明 | 国の権限ある当局の合理的な要求に応じて、ハイリスクAIシステムがシステム要件に適合していることを証明する。 | Section 2 |

| (l)アクセシビリティ要件 | 製品・サービス・公共機関のウェブサイト・モバイルアプリについて、ハイリスクAIシステムがアクセシビリティ要件に適合していることを保証する。 | 指令(EU) 2016/2102 および(EU) 2019/882 |

このほかにも、ハイリスクAIシステムの提供者に対して課される義務はさまざまなものがあります。特に留意すべきものとして、「認定代理人(authorised representative)の選任」(22条1項)と、「重大なインシデントの報告義務」(26条5項)が挙げられます。

ディプロイヤーに課せられる主な義務

AI法は、ハイリスクAIシステムのディプロイヤーに対して以下の義務を課しています(26条)。

| 要件 | 詳細 |

|---|---|

| 使用説明書に従った技術的・組織的措置 | システムの使用説明書に従って適切な技術的および組織的措置を講じる。 |

| 人間の監視 | 必要な能力、訓練、権限を持つ自然人に人的監視を割り当てる。 |

| 入力データの管理 | ディプロイヤーが入力データを管理する場合、そのデータが目的に対して適切であることを確認する。 |

| システムの監視 | 使用説明書に基づいてシステムの運用を監視し、リスクがある場合は提供者や市場監視当局に通知し、使用を中止する。 |

| ログの保持 | システムが自動生成するログを少なくとも6か月間保持する。 |

| 労働者への通知 | ディプロイヤーが雇用主である場合、職場でハイリスクAIシステムを使用する前に労働者代表および影響を受ける労働者に通知する。 |

| 公的機関の登録義務 | 公的機関のディプロイヤーは、EUデータベースに登録されていないシステムを使用しないようにし、提供者または販売業者に通知する。 |

| データ保護影響評価 | データ保護影響評価を実施するために必要な情報を使用する。 |

| 司法当局の承認 | 犯罪捜査のためにハイリスクAIシステムを使用する場合、事前または48時間以内に司法当局の承認を得る。 |

| 自然人への通知 | ハイリスクAIシステムが自然人に関する決定を行う場合、その使用について自然人に通知する。 |

| 当局との協力 | 関連当局がこの規則を実施するために取る行動に協力する。 |

このほかにも、ハイリスクAIシステムのディプロイヤーに対して課される義務はさまざまなものがあります。

日本企業におけるAI法対応の具体的なステップや実務ポイントの詳細は、以下の関連記事を参照ください。

森・濱田松本法律事務所外国法共同事業

森・濱田松本法律事務所外国法共同事業